Os planos do Google para o futuro: reunião virtual 3D, provador de roupas online e um assistente de IA para tudo

A gigante de tecnologia Google iniciou sua principal conferência anual para desenvolvedores, o Google I/O 2025, nesta terça-feira (20) no Shoreline Amphitheatre, em Mountain View, Califórnia (EUA).

O evento de dois dias está apresentando uma série de inovações que abrangem todo o portfólio da empresa, com destaque para significativos avanços em inteligência artificial (IA) e melhorias em seus principais produtos e serviços.

A seguir, o Olhar Digital compila as principais novidades trazidas pela big tech neste primeiro dia de evento.

Planos de assinatura: AI Ultra e AI Pro

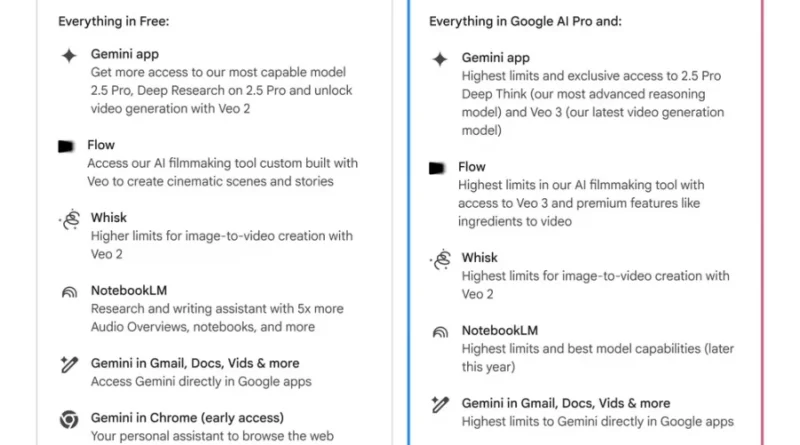

Em movimento para centralizar e expandir o acesso às suas tecnologias mais avançadas de IA, o Google revelou dois modelos de assinatura: o Google AI Ultra, de nível premium, e o aprimorado Google AI Pro, voltado a usuários e profissionais em busca de recursos extras sem custo adicional elevado.

AI Ultra: “passe VIP” para o ecossistema de IA do Google

Com mensalidade fixada em US$ 249,99 (R$ 1.417,17, na conversão direta), o AI Ultra promete à comunidade criativa, acadêmica e corporativa acesso irrestrito aos produtos mais potentes do Google:

- Gemini 2.5 Pro Deep Think: modo de raciocínio avançado, otimizado para tarefas matemáticas complexas e programação, com prioridade de acesso nas versões futuras;

- Veo 3 e Flow: gerações de vídeo de alta qualidade, incluindo edição assistida por IA, câmera virtual e limites máximos de resolução em 1080p;

- Whisk Animate: transforma imagens estáticas em clipes de até oito segundos, agora, com a potência do modelo Veo 2;

- NotebookLM: cadernos inteligentes com maior cota de uso e modelos de linguagem otimizados para pesquisa e ensino;

- Gemini integrado: respostas contextuais diretamente em Gmail, Documentos, Chrome e outros apps do Google, além do novo recurso de sumarização e execução de tarefas dentro do navegador;

- Project Mariner e Agent Mode: protótipos de agentes autônomos capazes de gerenciar simultaneamente até dez atividades – de buscas e reservas a compras online – e, em breve, realizar comandos complexos no desktop;

- Armazenamento de 30 TB: espaço compartilhado entre Drive, Photos e Gmail, ideal para grandes volumes de dados e criações multimídia;

- YouTube Premium: pacote individual incluído, com vídeos e músicas sem anúncios e acesso offline.

O AI Ultra já está disponível nos Estados Unidos, com desconto de 50% nos primeiros três meses para novos assinantes, e terá expansão gradual para outros mercados.

AI Pro: mais vantagens

Mantendo a proposta de democratizar o uso de IA sem o alto custo do Ultra, o Google elevou o AI Pro, agora por US$ 19,99/mês (R$ 113,32), incluindo:

- Fluxo de vídeo e edição via Flow, utilizando o modelo Veo 2;

- Capacidade ampliada no Gemini (antigo Gemini Advanced) e acesso antecipado ao assistente no Chrome;

- Transcrição e tradução simultânea no Google Meet (inglês e espanhol, com mais idiomas por vir);

- NotebookLM e outros apps com limites de uso superiores aos do plano gratuito.

Em esforço educacional, o Google estendeu gratuitamente o AI Pro por um ano letivo para estudantes universitários de países, como Brasil, Japão, Indonésia, Reino Unido e Estados Unidos.

Gemini Ultra: nova assinatura premium

Entre os principais anúncios, a empresa apresentou o Gemini Ultra, novo plano de assinatura premium disponível inicialmente apenas nos Estados Unidos.

De acordo com representantes da empresa, esta nova modalidade oferece “o mais alto nível de acesso” aos aplicativos e serviços com tecnologia de IA da Google.

Com valor mensal de US$ 249,99 (R$ 1.417,29, na conversão direta), o pacote inclui o gerador de vídeos Veo 3, o aplicativo de edição de vídeo Flow e acesso antecipado ao modo Deep Think do Gemini 2.5 Pro, funcionalidade de IA avançada ainda não disponível para o público geral (mais abaixo, falaremos do Veo 3 e do Deep Think).

Assinantes do Gemini Ultra também receberão limites superiores na plataforma NotebookLM e no Whisk, aplicativo de remixagem de imagens da empresa.

A assinatura premium contempla, ainda, acesso ao chatbot Gemini diretamente no navegador Chrome, ferramentas “agênticas” baseadas na tecnologia Project Mariner, YouTube Premium e 30 TB de armazenamento distribuídos entre Google Drive, Google Photos e Gmail.

Modelos de IA mais potentes

Entre as ferramentas de criação visual, o Google apresentou o Imagen 4, gerador de imagens por IA que promete ser consideravelmente mais rápido que seu antecessor.

A empresa anunciou planos para lançar, em um futuro próximo, uma variante do Imagen 4 até dez vezes mais veloz que o Imagen 3.

O novo modelo é capaz de renderizar “detalhes finos”, como tecidos, gotas de água e pelos de animais, podendo trabalhar com estilos tanto fotorrealistas quanto abstratos, criando imagens em uma variedade de proporções e com resolução de até 2K.

Ferramentas para desenvolvedores

Para a comunidade de desenvolvimento, a conferência trouxe o Stitch, ferramenta com tecnologia de IA projetada para auxiliar na criação de interfaces de usuário para web e aplicativos móveis, gerando os elementos de UI necessários e o código correspondente.

O Stitch pode ser instruído a criar interfaces de aplicativos com algumas palavras ou, mesmo, uma imagem, fornecendo marcação HTML e CSS para os designs gerados.

A big tech também expandiu o acesso ao Jules, seu agente de IA voltado para ajudar desenvolvedores a corrigir bugs em código.

A ferramenta auxilia os programadores a compreender códigos complexos, criar pull requests no GitHub e gerenciar determinados itens de backlog e tarefas de programação.

Project Mariner

O Project Mariner, agente experimental de IA do Google que navega e utiliza websites, recebeu atualizações significativas em seu funcionamento.

Agora, o agente pode executar quase uma dúzia de tarefas simultaneamente e está sendo disponibilizado para os usuários.

Com esta tecnologia, os usuários podem, por exemplo, comprar ingressos para um jogo de beisebol ou fazer compras de supermercado online sem visitar diretamente um site terceirizado, apenas conversando com o agente de IA do Google.

Project Astra

Já o Project Astra, experiência multimodal de IA de baixa latência da empresa, alimentará uma série de novas experiências no Google Search, no aplicativo do Gemini e em produtos de desenvolvedores terceirizados.

Originado no Google DeepMind como uma forma de demonstrar capacidades de IA multimodal em tempo quase real, a empresa revelou estar desenvolvendo óculos com tecnologia Project Astra em parceria com fabricantes, como Samsung e Warby Parker, embora ainda não haja data definida para lançamento.

Embora ainda restrito a um grupo seleto de avaliadores, o projeto não se destina ao consumidor final neste momento. Em vez disso, funciona como um laboratório experimental para explorar os limites do que uma IA pode fazer por seus usuários.

Greg Wayne, diretor de pesquisa da DeepMind, braço de inteligência artificial do Google, compara o Astra a um “carro conceito” – uma vitrine futurista das possibilidades de um assistente virtual completo, multimodal e autônomo. Segundo ele, o Astra é um vislumbre do que está por vir: um sistema inteligente que compreende, observa e age proativamente, quase como um companheiro digital.

Apesar de ainda estar em fase de testes, diversas tecnologias desenvolvidas no Astra já começaram a ser incorporadas em outras plataformas da empresa, como o Gemini e aplicativos complementares. Recursos, como respostas por voz, memória contextual e interações básicas com sistemas operacionais, estão entre as inovações que migraram para o uso público.

A cada nova funcionalidade absorvida por outros produtos, o time do Astra volta ao ponto de partida, explorando novos caminhos para tornar o assistente cada vez mais sofisticado.

Uma das novidades mais impactantes é a capacidade de agir de forma proativa: o sistema, agora, é capaz de iniciar interações sem depender de comandos diretos do usuário. Essa mudança representa salto significativo em relação à lógica tradicional dos assistentes virtuais, que, normalmente, aguardam instruções explícitas para atuar.

Wayne explica que o Astra passa a “observar continuamente os acontecimentos ao redor e decide, com base nesses eventos, quando intervir e como”. A ideia é que o assistente esteja permanentemente atento, analisando o ambiente por meio de câmeras e microfones, especialmente em dispositivos como smartphones e óculos inteligentes, que podem tornar essa vigilância constante mais natural.

Em cenário prático, por exemplo, se o usuário estiver resolvendo exercícios escolares e cometer um erro, o Astra pode identificar a falha em tempo real e corrigi-la imediatamente, sem precisar ser solicitado. Em outra situação, se a pessoa estiver seguindo uma dieta com jejum intermitente, o sistema pode lembrar o horário ideal para se alimentar — ou sugerir que espere mais um pouco.

Demis Hassabis, CEO do Google DeepMind, enfatiza que ensinar uma máquina a “ler o ambiente”, ou seja, compreender contexto social, emocional e situacional, é um desafio monumental. Saber quando falar, como abordar um problema, ou quando ficar em silêncio, exige níveis de sensibilidade que ainda estão longe da realidade da IA moderna.

“É um tipo de inteligência completamente diferente da que usamos para treinar modelos convencionais”, afirma Hassabis. Segundo ele, se o assistente falhar nesse equilíbrio e se tornar intrusivo, o risco é que os usuários simplesmente deixem de utilizá-lo. Essa é a linha tênue que os engenheiros tentam não ultrapassar.

Outro avanço significativo é a capacidade do Astra de acessar informações de diferentes serviços da Google.

O assistente consegue consultar agendas no Google Calendar, localizar e-mails com dados relevantes, como números de confirmação em reservas, e, até, avisar o momento certo de sair para um compromisso. Além disso, o sistema já começa a operar no Android, interagindo com aplicativos e configurações de forma quase autônoma.

Bibo Xiu, gerente de produto da equipe DeepMind, demonstrou essa funcionalidade em tempo real. Apontando a câmera de seu celular para um fone da Sony, pediu que o Astra identificasse o modelo e, em seguida, solicitou ajuda para pareá-lo com o smartphone. A assistente virtual, após identificar o aparelho, acessou as configurações do Android e iniciou o emparelhamento sozinha — um processo que antes exigiria várias etapas manuais.

Embora ainda restrito a um grupo seleto de avaliadores, o projeto não se destina ao consumidor final neste momento. Em vez disso, funciona como um laboratório experimental para explorar os limites do que uma IA pode fazer por seus usuários.

Greg Wayne, diretor de pesquisa da DeepMind, braço de inteligência artificial do Google, compara o Astra a um “carro conceito” – uma vitrine futurista das possibilidades de um assistente virtual completo, multimodal e autônomo. Segundo ele, o Astra é um vislumbre do que está por vir: um sistema inteligente que compreende, observa e age proativamente, quase como um companheiro digital.

Apesar de ainda estar em fase de testes, diversas tecnologias desenvolvidas no Astra já começaram a ser incorporadas em outras plataformas da empresa, como o Gemini e aplicativos complementares. Recursos, como respostas por voz, memória contextual e interações básicas com sistemas operacionais, estão entre as inovações que migraram para o uso público.

A cada nova funcionalidade absorvida por outros produtos, o time do Astra volta ao ponto de partida, explorando novos caminhos para tornar o assistente cada vez mais sofisticado.

Uma das novidades mais impactantes é a capacidade de agir de forma proativa: o sistema, agora, é capaz de iniciar interações sem depender de comandos diretos do usuário. Essa mudança representa salto significativo em relação à lógica tradicional dos assistentes virtuais, que, normalmente, aguardam instruções explícitas para atuar.

Wayne explica que o Astra passa a “observar continuamente os acontecimentos ao redor e decide, com base nesses eventos, quando intervir e como”. A ideia é que o assistente esteja permanentemente atento, analisando o ambiente por meio de câmeras e microfones, especialmente em dispositivos como smartphones e óculos inteligentes, que podem tornar essa vigilância constante mais natural.

Em cenário prático, por exemplo, se o usuário estiver resolvendo exercícios escolares e cometer um erro, o Astra pode identificar a falha em tempo real e corrigi-la imediatamente, sem precisar ser solicitado. Em outra situação, se a pessoa estiver seguindo uma dieta com jejum intermitente, o sistema pode lembrar o horário ideal para se alimentar — ou sugerir que espere mais um pouco.

Demis Hassabis, CEO do Google DeepMind, enfatiza que ensinar uma máquina a “ler o ambiente”, ou seja, compreender contexto social, emocional e situacional, é um desafio monumental.

Saber quando falar, como abordar um problema, ou quando ficar em silêncio, exige níveis de sensibilidade que ainda estão longe da realidade da IA moderna.

“É um tipo de inteligência completamente diferente da que usamos para treinar modelos convencionais”, afirma Hassabis. Segundo ele, se o assistente falhar nesse equilíbrio e se tornar intrusivo, o risco é que os usuários simplesmente deixem de utilizá-lo. Essa é a linha tênue que os engenheiros tentam não ultrapassar.

Outro avanço significativo é a capacidade do Astra de acessar informações de diferentes serviços da Google. O assistente consegue consultar agendas no Google Calendar, localizar e-mails com dados relevantes, como números de confirmação em reservas, e, até, avisar o momento certo de sair para um compromisso. Além disso, o sistema já começa a operar no Android, interagindo com aplicativos e configurações de forma quase autônoma.

Bibo Xiu, gerente de produto da equipe DeepMind, demonstrou essa funcionalidade em tempo real. Apontando a câmera de seu celular para um fone da Sony, pediu que o Astra identificasse o modelo e, em seguida, solicitou ajuda para pareá-lo com o smartphone. A assistente virtual, após identificar o aparelho, acessou as configurações do Android e iniciou o emparelhamento sozinha — um processo que antes exigiria várias etapas manuais.

Apesar de ainda exigir que certos recursos sejam ativados manualmente (como a visualização da tela pelo assistente), o objetivo é tornar tudo isso automático no futuro. Essa direção segue uma tendência também adotada pela Apple com a evolução da Siri: criar um assistente verdadeiramente operacional, capaz de navegar por aplicativos, ajustar definições, responder a mensagens e executar tarefas com autonomia total.

Apesar de ainda exigir que certos recursos sejam ativados manualmente (como a visualização da tela pelo assistente), o objetivo é tornar tudo isso automático no futuro. Essa direção segue uma tendência também adotada pela Apple com a evolução da Siri: criar um assistente verdadeiramente operacional, capaz de navegar por aplicativos, ajustar definições, responder a mensagens e executar tarefas com autonomia total.

Leia mais:

- Google Drive: 8 truques escondidos que vão aprimorar sua navegação na plataforma

- Google: como usar documentos, planilhas e apresentações off-line

- O plano da Europa para depender menos do Google

Melhorias no Google Search e workspace

No âmbito das ferramentas de busca, o Google anunciou a implementação do AI Mode, recurso experimental que permite aos usuários fazer perguntas complexas e de múltiplas partes por meio de uma interface de IA. O recurso estará disponível para usuários nos EUA ainda esta semana.

O AI Mode oferecerá suporte ao uso de dados complexos em consultas esportivas e financeiras, além de opções “experimente” para vestuário.

Já o Search Live, previsto para ser lançado em meados de setembro deste ano, permitirá aos usuários fazer perguntas com base no que a câmera do telefone está vendo em tempo real. O Gmail será o primeiro aplicativo a ser compatível com contexto personalizado.

A conferência também marcou a apresentação do Beam, anteriormente chamado Starline, tecnologia de teleconferência 3D que utiliza combinação de software e hardware, incluindo conjunto de seis câmeras e display customizado de campo de luz.

O sistema permite que um usuário converse com alguém como se estivessem na mesma sala de reunião, convertendo o vídeo das câmeras, posicionadas em diferentes ângulos e direcionadas ao usuário, em renderização 3D.

O Beam oferece rastreamento de cabeça em nível milimétrico “quase perfeito” e streaming de vídeo a 60fps. Quando usado com o Google Meet, proporciona um recurso de tradução de voz em tempo real com tecnologia de IA que preserva a voz, o tom e as expressões originais do falante (saiba mais sobre o Beam abaixo).

IA em toda parte

O Google está lançando o Gemini no Chrome, que dará, às pessoas, acesso a novo assistente de navegação com IA que as ajudará a compreender, rapidamente, o contexto de uma página e realizar tarefas.

Além disso, o Gemma 3n, modelo projetado para funcionar “sem problemas” em telefones, laptops e tablets, está disponível em prévia desde esta terça-feira (20), podendo processar áudio, texto, imagens e vídeos.

A empresa anunciou também uma série de recursos de IA para o Workspace, incluindo Gmail, Google Docs e Google Vids. Entre as novidades mais significativas, o Gmail ganhará respostas inteligentes personalizadas e novo recurso de limpeza de caixa de entrada, enquanto o Vids receberá novas formas de criar e editar conteúdo.

Os Video Overviews chegarão ao NotebookLM, e a empresa lançou o SynthID Detector, portal de verificação que utiliza a tecnologia de marca d’água SynthID do Google para ajudar a identificar conteúdo gerado por IA. O Lyria RealTime, modelo de IA que alimenta seu aplicativo experimental de produção musical, agora está disponível via API.

Wear OS 6 e melhorias para o Google Play

O Wear OS 6 traz uma fonte unificada para os tiles, proporcionando aparência mais limpa aos aplicativos, enquanto os Pixel Watches receberão temas dinâmicos que sincronizam as cores dos aplicativos com os mostradores dos relógios.

A principal promessa da nova plataforma de referência de design é permitir que os desenvolvedores criem melhor personalização em aplicativos, junto com transições perfeitas. A empresa está lançando diretrizes de design para desenvolvedores junto com arquivos de design Figma.

No Google Play, a empresa implementa ferramentas aprimoradas para desenvolvedores Android lidarem com assinaturas, páginas de tópicos para que os usuários possam mergulhar em interesses específicos, amostras de áudio para oferecer prévia do conteúdo do aplicativo e nova experiência de checkout para facilitar a venda de complementos.

Páginas de navegação por tópicos para filmes e programas (disponíveis inicialmente apenas nos EUA) conectarão os usuários a aplicativos vinculados a inúmeros programas e filmes.

Além disso, os desenvolvedores receberão páginas dedicadas para teste e lançamentos, bem como ferramentas para monitorar e melhorar o lançamento de seus aplicativos. Os desenvolvedores que usam o Google, agora, também podem interromper lançamentos de aplicativos ativos caso surja um problema crítico.

As ferramentas de gerenciamento de assinaturas também estão sendo aprimoradas com checkout de múltiplos produtos. Em breve, os desenvolvedores poderão oferecer complementos de assinatura com assinaturas principais, tudo em único pagamento.

Android Studio com recursos de IA

O Android Studio está integrando novos recursos de IA, incluindo “Journeys”, recurso de “IA agêntica” que coincide com o lançamento do modelo Gemini 2.5 Pro. Um “Modo Agente” será capaz de lidar com processos de desenvolvimento mais intrincados.

O Android Studio receberá, ainda, novas capacidades de IA, incluindo um recurso aprimorado de “crash insights” no painel App Quality Insights. Esta melhoria, alimentada pelo Gemini, analisará o código-fonte de um aplicativo para identificar possíveis causas de falhas e sugerir correções.

Android XR

A integração entre IA e realidade estendida (RE) está ganhando novo capítulo com os avanços do Google no desenvolvimento de dispositivos vestíveis.

A empresa apresentou, no Google I/O, detalhes inéditos sobre a fusão entre a nova plataforma Android XR e o Gemini, projetada para funcionar em óculos e headsets com o objetivo de oferecer experiência de uso mais natural, intuitiva e integrada ao cotidiano.

A ideia central é ambiciosa: permitir que a IA veja, ouça e compreenda o mundo a partir do ponto de vista do usuário, sem a necessidade de comandos manuais.

Com os novos óculos equipados com Android XR, o assistente digital se torna presença constante e quase invisível, pronto para agir a qualquer momento — sem que o usuário precise tirar o telefone do bolso.

Essa é a primeira versão do Android XR concebida já dentro do ecossistema do Gemini, sinalizando mudança de paradigma no uso de assistentes virtuais. A tecnologia permite que óculos inteligentes e headsets se conectem ao smartphone, ampliando, significativamente, as capacidades de interação entre o usuário e a IA.

O sistema, desenvolvido em parceria com a Samsung e a Qualcomm, estreia em dispositivos, como o Project Moohan — headset imersivo da sul-coreana previsto para lançamento ainda este ano (e que apareceu de relance no Galaxy Unpacked 2025).

Esses aparelhos prometem experiências visuais expansivas, como uma “tela infinita” que se adapta ao ambiente do usuário. A integração com o Gemini permite que o dispositivo reconheça o que está ao redor e tome decisões de forma autônoma, como iniciar tarefas, fornecer informações ou traduzir conversas em tempo real.

Os novos óculos com Android XR foram apresentados como evolução do conceito de “smart glasses”, que o Google vem explorando há mais de uma década. Equipados com câmeras, microfones e alto-falantes, eles se conectam ao telefone do usuário e oferecem acesso contínuo a aplicativos e informações, sem a necessidade de toques ou telas.

Um dos diferenciais está na tela interna opcional, que projeta informações diretamente nas lentes de forma discreta e privada. Isso permite, por exemplo, visualizar direções, mensagens ou traduções simultâneas sem interromper a atividade em andamento. A IA é capaz de entender o ambiente, lembrar preferências e auxiliar em tempo real, tornando-se extensão cognitiva do próprio usuário.

Na demonstração ao vivo, os óculos foram usados para agendar compromissos, responder mensagens, fotografar, solicitar direções passo a passo e até realizar traduções bilaterais durante uma conversa — com legendas exibidas para cada interlocutor. O recurso tem potencial para romper barreiras linguísticas de forma inédita, oferecendo espécie de “legenda ao vivo” para o mundo real.

Ciente de que a aceitação do público passa também pela estética e conforto, o Google está investindo em parcerias com marcas de moda e design de óculos. As primeiras colaborações incluem nomes, como Gentle Monster e Warby Parker, com foco em criar modelos que sejam, ao mesmo tempo, tecnológicos e elegantes.

A empresa também revelou que trabalha com a Kering Eyewear e outras fabricantes para expandir o portfólio de dispositivos, unindo funcionalidade à usabilidade cotidiana.

O objetivo é tornar os óculos tão desejáveis quanto qualquer outro acessório de uso diário. Essa estratégia da big tech é semelhante ao que a Meta fez ao se unir com a Ray-Ban.

Além disso, Google e Samsung estão estendendo sua colaboração para além dos headsets, criando base de software e hardware de referência para facilitar o desenvolvimento de novos modelos de óculos compatíveis com o Android XR.

A expectativa é que desenvolvedores possam começar a criar soluções para a nova plataforma ainda este ano.

Reconhecendo os desafios éticos e de privacidade envolvidos, o Google afirma que está conduzindo testes controlados com usuários de confiança para colher feedback sobre os primeiros protótipos. A empresa enfatiza o compromisso com a proteção dos dados do usuário e das pessoas ao seu redor, buscando criar equilíbrio entre utilidade e respeito à privacidade.

Nos próximos meses, mais detalhes devem ser divulgados à medida que os testes avançam e novas versões dos dispositivos sejam refinadas. Para o Google, óculos inteligentes não são apenas uma evolução tecnológica, mas nova forma de conectar o ser humano ao mundo digital — de maneira mais fluida, prática e invisível.

Provador virtual com IA

O Google começou a distribuir, nos EUA, duas inovações que prometem transformar a experiência de compras online: um provador virtual baseado em IA e um modo de pesquisa “agêntico” capaz de concluir transações sem que o usuário precise sair do navegador.

Já disponível no Search Labs, o novo recurso permite, ao internauta, experimentar virtualmente roupas usando a própria foto.

Para acessar o sistema, basta ativar o experimento no ambiente de testes do Google e, ao buscar por calças, camisas, vestidos ou saias, clicar no botão “experimentar” que surge ao lado dos resultados.

Em seguida, a plataforma solicita uma fotografia de corpo inteiro do usuário e gera, em segundos, uma imagem realista do modelo de roupa sobreposto a seu corpo.

Segundo a empresa, a tecnologia se apoia em modelo de IA treinado para compreender as particularidades anatômicas e têxteis, reproduzindo, fielmente, como diferentes tecidos se acomodam, esticam e dobram em silhuetas variadas.

Além de visualizar o resultado, o provador vitrrual permite, ao usuário, salvar ou compartilhar o look digital — ferramenta essa que pode auxiliar na decisão de compra e reduzir o volume de devoluções.

Paralelamente, o Google amplia o AI Mode, experiência de pesquisa assistida pelo Gemini, liberada gradativamente desde março.

Ao informar ao assistente virtual um objetivo específico — por exemplo, “preciso de uma bolsa de viagem para maio em Portland, Oregon” — o sistema realiza múltiplas buscas simultâneas, identificando produtos que atendam a critérios, como resistência à chuva, compartimentos extras e design compacto.

Os resultados são reunidos em painel personalizado, onde o usuário pode ajustar detalhes (cor, tamanho, orçamento) sem reescrever consultas.

Nos próximos meses, o Google ativará também nova função “agêntica” de checkout automático. Após selecionar “acompanhar preço” em um anúncio, definir preferências de tamanho e faixa de preço, o consumidor receberá alerta quando o valor desejado for alcançado e poderá optar por “comprar para mim”.

A partir daí, o sistema preenche os campos no site do vendedor e finaliza o pagamento com segurança via Google Pay, passando ao usuário apenas a confirmação da transação.

Beam: plataforma de vídeo 3D

O Google anunciou, oficialmente, o Beam, evolução do antigo Project Starline, com o objetivo de transformar encontros virtuais em experiências próximas à presença física.

A nova plataforma, alicerçada em modelos avançados de IA e infraestrutura do Google Cloud, promete exibir conversas em três dimensões, tornando possível olhar nos olhos do interlocutor, captar sutis expressões faciais e criar senso de profundidade sem o uso de óculos ou headsets especiais.

No coração do Beam está sofisticado modelo de vídeo volumétrico, capaz de converter imagens bidimensionais em panoramas 3D realistas.

Graças a esta IA, a transmissão ganha múltiplos pontos de vista em tempo real, permitindo que o usuário experimente a chamada de diferentes ângulos — exatamente como em uma conversa presencial.

A renderização e o processamento volumétrico são executados na nuvem do Google, garantindo escalabilidade e compatibilidade com fluxos de trabalho empresariais existentes.

Para exibir essa profundidade de forma natural, o Beam utiliza telas de light field display, que projetam várias camadas de imagem que se combinam nos olhos do espectador.

O resultado é uma ilusão convincente de tridimensionalidade, na qual gestos e expressões são percebidos com clareza. Segundo executivos do Google, esse avanço tecnológico permite não apenas melhorar a comunicação, mas, também, reforçar a empatia e confiança entre os participantes.

Em paralelo à inovação visual, o Beam aposta em recursos de tradução de voz em tempo real, já disponível em testes no Google Meet.

O sistema preserva o timbre, o ritmo e as nuances emocionais de cada falante, oferecendo conversas bilíngues fluídas e autênticas. A ideia é derrubar barreiras linguísticas, possibilitando que equipes globais colaborem sem depender de intérpretes externos.

A estreia comercial do Google Beam está prevista para este ano, em parceria com a HP, que fabricará os primeiros dispositivos dedicados à tecnologia.

As demonstrações começarão na feira InfoComm, enquanto empresas, como Deloitte, Salesforce e Duolingo, já manifestaram interesse nos pilotos.

Além disso, o Google firma acordos com integradores de sistemas, como Diversified e AVI-SPL, e plataformas de videoconferência, incluindo o Zoom, para facilitar a adoção do Beam em organizações de diversos setores.

Outras revelações

O Google trouxe outras novidades no I/O 2025 e que reportamos no Olhar Digital. A seguir, você confere um a um:

- O app do Gemini ganhou sete grandes atualizações, como o Gemini Live com câmera e o Veo 3, que cria vídeos, sons, falas ruídos realistas;

- O sistema de busca da big tech também vai seguir com a ampliação dos AI Overviews, sistema de IA do Google que resume, de forma sucinta, o que a pessoa está procurando, evitando que ela precise clicar em vários links;

- Mais uma novidade no aplicativo do Gemini é o “Modo Agente”, que receberá tarefas de usuários e as executará, como buscas por um apartamento em certa cidade;

- O Gemini 2.5 ganhou boas melhorias, sendo a mais sonante delas o Deep Think, o que faz com que a IA do Google se equipare aos rivais ao conseguir pensar profundamente antes de responder;

- O Gmail vai usar o Gemini para elaborar respostas inteligentes baseadas em e-mails e no Drive, visando trazer sugestões mais completas;

- O Gemini 2.5 Flash, modelo de raciocínio do Google, vai ficar melhor “em quase todos os aspectos”, Disse Demis Hassabis, chefe da divisão DeepMind;

- O Google Meet trará um recurso que te “dublará” em tempo real ao conversar com pessoas que falam outros idiomas.

O post Os planos do Google para o futuro: reunião virtual 3D, provador de roupas online e um assistente de IA para tudo apareceu primeiro em Olhar Digital.